十年前,我在微軟研究院語音組混日子。 混,不是我的主觀意願,卻是客觀事實。 當時,我們做的“人機交互”離實用太遠,別人都認為我們是編了個故事來騙工資的。 有一回,跟同學聊起我們的願景:“將來,您對著電腦,樂意怎麼說怎麼說,那邊不光嗯啊嗻是,有來言就有去語,回答的還得像話。”正說 著,他打斷了我:“你說的這不是跳大神,讓狐仙附了體了麼?”

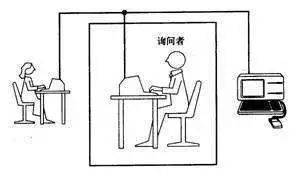

這當然是戲言,因為建國以後就不許成精了。 覺得這事兒挺扯的,要怨您就怨一位前輩的老先生——圖靈。 是他在人工智能八字還沒一撇的時候,提出了這個終極測試方案:將人與機器隔開,前者通過一些裝置向後者隨意提問。 多次問答後,如果有超過30%的人不能確定出被測試者是人還是機器,那麼這台機器就通過了測試,並被認為具有人類智能。

於是,通過圖靈測試,就成了所有人工智能科學家和偽科學家的最高目標。 這兩年人工智能大火,號稱通過了圖靈測試的產品,也如雨後春筍般湧現,甚至可以一抬腳踩死一片。 最近的一次,是谷歌在Google I/O大會上演示的Deplux,據說“部分通過圖靈測試”,這倒還算中肯。

看起來,圖靈的棺材板快壓不住了,我們是否已經到了突破圖靈測試的奇點了呢? 我正在一頭霧水之際,突然有天晚上,黑暗暗霧沉沉,圖爺托兆給我,對我言道:“這事兒,還離著六扔多遠吶!現傳爾秘籍一部 ,望爾潛心習學,授眾生以三法門!”哪三個法門? 且看下文分解。

圖靈測試是不是人機“對話”?

理解概念,要把握其內涵和外延。 圖靈測試的內涵很清楚,就是用機器替代人,進行信息交互。 不過其外延有些不清,頗多可變通之處,比如那個“一些裝置”。 時下的相關產品,交互或用文字,或用語音,對於信息溝通來說,這樣的裝置夠用麼?

我們知道,對人類來說,文字僅僅承載著內容的溝通。 而 人人信息交互,內容溝通大概只佔20%,情感溝通要占到80%。 計算廣告群裡的九千歲講了個生動的例子:當年他給女朋友打電話,信息量最大的,就是對方拿起電話那一聲“餵”,這個“餵”就為今天幾個鐘頭的 會談定下了基調。

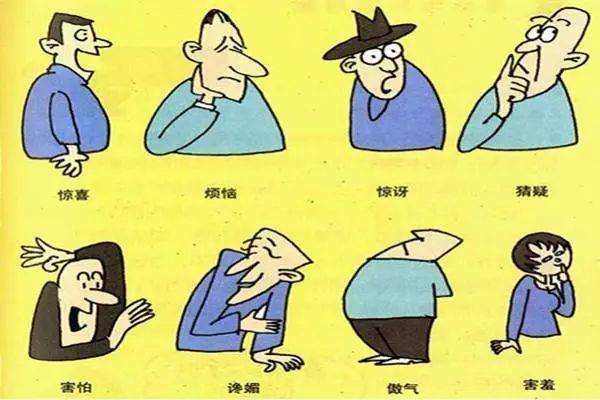

情感溝通,要理解的就不僅僅是文字,還包括語音、表情、肢體語言等等。 所以,兩個在知乎上吵得不可開交的人,打個電話沒準就成了基友;而真正重要的面試、會議,還是必鬚麵對面進行。 沒有對這些副語言現象深入研究建模,即使完美地解決了文字和內容溝通的問題,也離真正有效的人機交互相去甚遠。

因此,人機“交互”絕非人機“對話”,我認為真正理想的圖靈測試,就算不能聲情並茂地反饋用戶,也至少應該能察言觀色,有效解讀用戶的副語言。 將來用上機器女友了,人家“餵”了一聲,你還不知道怎麼接茬儿,那還不等著回家跪電路板?

顯然,這樣去限定圖靈測試的話,我們現在仍然束手無策。 飯要一口口吃,先降低下難度,僅僅考慮利用文本或語音跟機器聊天的場景,我們今天看到的Siri、小冰、Alexa、叮咚音箱等,都是這樣的人機對話系統。 那麼,是否在人機“對話”的情形下,通過圖靈測試已經指日可待了呢?

既然不用理解副語言現象,人機對話的關鍵,當然就是理解自然語言了。 自然語言理解和人機對話,是認知智能領域的核心問題,要了解它遇到的困難,要先從目前人工智能的實用方法說起。

人機對話到底難在哪裡?

今天所有實用的人工智能產品,都是用的“弱智” 方法 。 簡單來說,就是湊答案:準備一大坨標註好的數據,然後用大量機器堆上去狂撩,直到把答案湊個八九不離十。 至於問題的內在邏輯和簡約規律,今天的AI無心顧及,也無力解讀。

“弱智”方法在數據充沛的領域,可謂所向披靡:無論是語音識別、人臉識別,還是機器翻譯、各種棋類,機器都已經接近乃至碾壓真人了。 且慢! 機器翻譯都快解決了麼? 翻譯可比聊天要難吧? 不然,機器翻譯這個問題,答案是比較好湊的:找到足夠多的語言對數據,把詞譯過去跟麻將牌一樣碼好了,再調整一下順序即可。 人機對話則不然,我們要找到對方語言裡的關鍵信息,把它轉化為動作,再把動作的結果反饋回去。 這些關鍵信息處理的過程,是要經過統計意義上的推理過程。

說到推理,當然離不開句子表達內容以外的背景知識。 比如你問機器:“直徑為10的球體積是多少?”機器就得會球的體積公式才算得出來。 當然,微積分、背古詩、查法典這樣的知識,對機器來說總是可以解決,因為有大量書本上的語料可供學習,按照“弱智”方法湊答案即可。 難就難在,這世界上還有大量的知識,根本沒地方學去。

直覺上,人的知識來自於六歲以後的學習。 實際上,絕大部分知識都來自於六歲前神奇的積累過程。 只不過,這些知識太普通了,連傻子都知道,所以被大家都選擇性地遺忘了。 這種人人皆知的事情,姑且把它叫做“常識”,舉兩個例子您就明白了:

小明面對著你,你瞧不見小明的後腦勺

一瓶礦泉水被我喝完了,瓶子變輕了

就這個呀? 這玩意也算知識? 您別拿村長不當乾部,沒有這些常識的支撐,自然語言推理是進行不下去的,不信您看看下面這兩句:

爸爸快抱不動兒子了,因為他太胖了

爸爸快抱不動兒子了,因為他太虛弱了

後半句的這個“他”,在上下兩句指代的對像是不同的。 顯然,沒有常識的支撐,這兩句不好理解。 悲催之處在於,這些常識,在所有人類積累的語料當中是不存在的。 您想想,有人要編纂一本專著,裡面寫的全是這樣的“深奧”知識:

有孤王坐金殿脊背朝後

頭衝上腳衝下臉衝前頭

走三步退三步如同沒走

兩隻手伸出來十個指頭

那讀者還不得罵著街把作者押送到精神病院啊? 對此,郭德綱老師和其它曲藝界同仁給了個專業術語,叫“大實話”。

沒有了語料、也就是數據的支撐,“弱智”方法是沒辦法獲取這些常識的。 所以,甭管誰說他的對話系統通過了圖靈測試,你也別問它化學方程,也別讓它背誦古文,就找幾個這樣的真·弱智問題問上一問,它要能答 出來我是茄子,那就挺厲害的了。

那麼人類的常識在六歲前是怎麼獲得的呢? 對於這樣的學術問題,我只能嚴肅地回答你:“問村長去!”

人機交互要不要模仿人人交互?

看起來,我們離通過圖靈測試,還真有六扔多遠。 那麼,從應用的角度看,人機交互這件事真的遙不可及麼? 這倒也未必。

從開始探索人機交互,我們就想當然地認為,把人人交互的那一端由人變成機器,就是人機交互的理想模式了。 於是,我們設計出來的機器人,也都是倆肩膀扛個腦袋,四肢五官齊備,用語言的方式跟對面的人類交流,再加上對常識一竅不通,怎麼看怎麼像個二傻子。

問題出在哪兒了呢? 人類的信息交互,最高效的輸出方式是“說”,也就是音頻通道;最高效的輸入方式是“看”,也就是視頻通道。 如果你對面是個真人,那沒辦法,雙方都只能靠說輸出信息,這就形成了語音為主的交互方式。 而靠語音的人機對話,是這樣的畫風:

我想訂一張明天去上海的機票

為您查到:6:35海南航空HU7611,票價480元;6:50吉祥航空HO252,438元;6:50廈門航空MF8178,票價……

我去你大爺的吧!

別樂,就算對面不是機器是個真人客服,這種交互也同樣令人抓狂,有過電話訂票經歷的朋友都有體會,只不過對著活人您不好意思罵街罷了。

既然對面是個機器人,就沒必要如此拘泥了。 實際上,機器的交互方式,應該跟我們“相反”而不是“相同” :你輸出信息靠說,機器人接受信息就得靠聽,這沒錯;你輸入信息靠看,那機器人輸出就別靠說了,何不在一塊屏上展示出來呢? 這樣不但信息輸出效率提高了很多,而且用戶只要在展示的信息底板上做選擇題,就算用語音輸入也大為便捷。

所以,真正適合人機交互的機器人,最好有個視頻輸出的設備,近了靠手機就可以,遠了怎麼辦還值得探討。 這個概念,就是訊飛的胡鬱老師講的“強視覺呈現的語音交互”吧。 這種模式下的交互方式,已經跟人人交互有了質的區別,未知之處很多,需要我們深入探索。 當然,可以確定的是, 機器人絕對應該拋棄人形,以避免用戶用人的眼光和標準來評價它。

人機交互這件事,看起來簡單,卻是人工智能王冠上最耀眼的一顆明珠。 目前看來,嚴格意義上的圖靈測試離我們還相當遙遠,不過通過交互方式和產品上的創新,一個在特定領域內可用的合格助手,或許已經在向我們招手了。

另外,由於計算機對海量信息的檢索和處理能力遠勝人類,或許可以讓機器助手輔助人人交互,這樣既能大大提高內容溝通效率,又能發揮人的情感溝通優勢,這沒準是目前更加可行 的產品路線。

*文章為作者獨立觀點,不代表虎嗅網立場

本文由 計算廣告© 授權 虎嗅網 發表,並經虎嗅網編輯。 轉載此文章須經作者同意,並請附上出處( 虎嗅網 )及本頁鏈接。 原文鏈接https://www.huxiu.com/article/247451.html

http://www.buzzfunnews.com/20180620107.html

每日頭條即時更新,請上:http://www.buzzfunnews.com

沒有留言:

張貼留言